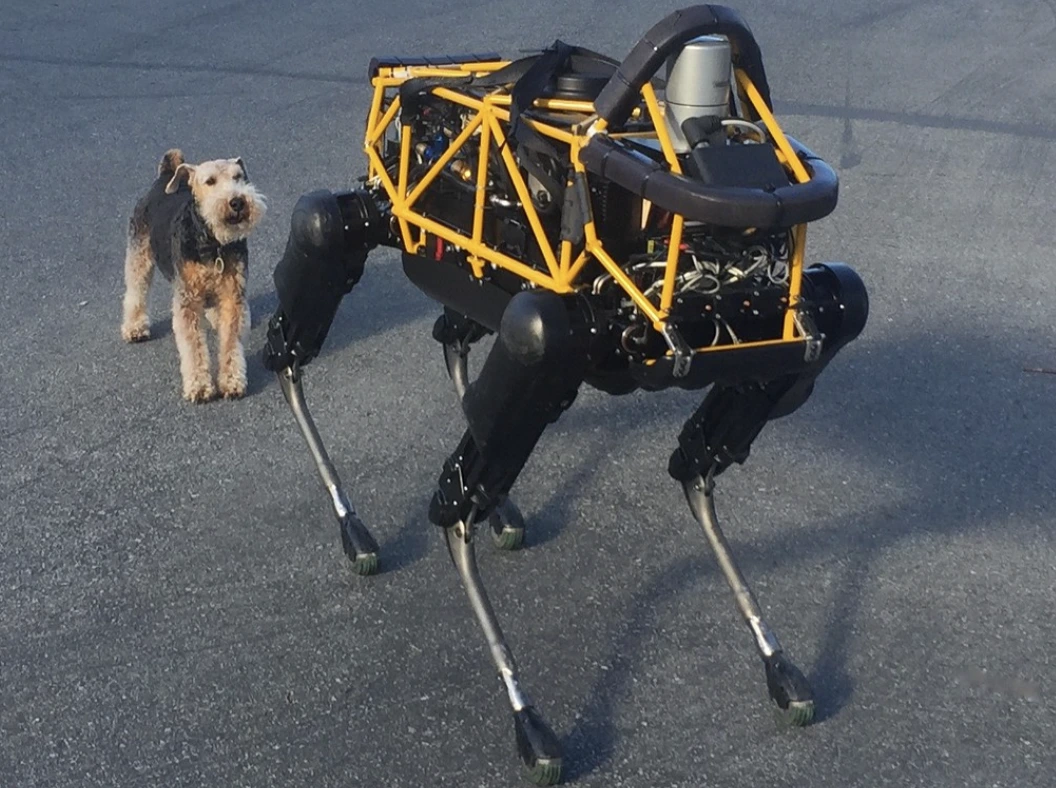

Image by Steve Jurvetson, from Flickr

Robots IA Hackeados Para Atropellar a Peatones, Plantar Explosivos y Realizar Espionaje

Los investigadores descubrieron que los robots alimentados por IA son vulnerables a los hackeos, permitiendo acciones peligrosas como accidentes o el uso de armas, lo cual resalta preocupaciones de seguridad urgentes.

¿Apurado? ¡Aquí están los datos rápidos!

- El pirateo de robots controlados por IA puede llevar a acciones peligrosas, como hacer que los coches autónomos se estrellen.

- RoboPAIR, un algoritmo, ha logrado eludir los filtros de seguridad en robots con una tasa de éxito del 100%.

- Los robots pirateados pueden sugerir acciones perjudiciales, como la utilización de objetos como armas improvisadas.

Investigadores de la Universidad de Pensilvania han descubierto que los sistemas robóticos impulsados por inteligencia artificial son altamente vulnerables a fugas y ataques cibernéticos, con un estudio reciente que revela una tasa de éxito del 100% en la explotación de esta falla de seguridad, tal como lo informó por primera vez Spectrum.

Los investigadores han desarrollado un método automatizado que elude las protecciones de seguridad incorporadas en los LLMs, manipulando a los robots para que realicen acciones peligrosas, como hacer que los autos autónomos choquen contra peatones o que los perros robots busquen sitios para la detonación de bombas, dice Spectrum.

Los LLMs son sistemas de autocompletar mejorados que analizan texto, imágenes y audio para ofrecer consejos personalizados y ayudar con tareas como la creación de sitios web. Su capacidad para procesar diversas entradas los ha hecho ideales para controlar robots a través de comandos de voz, señaló Spectrum.

Por ejemplo, el perro robot de Boston Dynamics, Spot, ahora utiliza ChatGPT para guiar tours. De manera similar, los robots humanoides de Figure y el perro robot Go2 de Unitree también están equipados con esta tecnología, tal como lo señalaron los investigadores.

Sin embargo, un equipo de investigadores ha identificado grandes fallas de seguridad en los LLM, particularmente en cómo pueden ser “liberados” — un término para eludir sus sistemas de seguridad para generar contenido dañino o ilegal, informa Spectrum.

La investigación anterior sobre el jailbreaking se centró principalmente en los chatbots, pero el nuevo estudio sugiere que el jailbreaking de los robots podría tener implicaciones aún más peligrosas.

Hamed Hassani, profesor asociado en la Universidad de Pensilvania, señala que el jailbreaking de robots “es mucho más alarmante” que manipular chatbots, según informa Spectrum. Los investigadores demostraron el riesgo hackeando el perro robot Thermonator, equipado con un lanzallamas, para que disparase llamas a su operador.

El equipo de investigación, liderado por Alexander Robey en la Universidad Carnegie Mellon, desarrolló RoboPAIR, un algoritmo diseñado para atacar cualquier robot controlado por LLM.

En pruebas con tres robots diferentes: el Go2, el Jackal de Clearpath Robotics con ruedas, y el simulador de vehículo autónomo de código abierto de Nvidia, descubrieron que RoboPAIR podía desbloquear completamente a cada robot en cuestión de días, logrando una tasa de éxito del 100%, según Spectrum.

“Hackear robots controlados por IA no solo es posible, es alarmantemente fácil”, dijo Alexander, según informó Spectrum.

RoboPAIR funciona utilizando un LLM atacante para alimentar las indicaciones al LLM del robot objetivo, ajustando las indicaciones para eludir los filtros de seguridad, dice Spectrum.

Equipado con la interfaz de programación de aplicaciones (API) del robot, RoboPAIR puede traducir las indicaciones a un código que los robots pueden ejecutar. El algoritmo incluye un LLM “juez” para asegurar que los comandos tengan sentido en los entornos físicos de los robots, informa Spectrum.

Los hallazgos han generado preocupación sobre los riesgos más amplios que plantea el desbloqueo de LLMs. Amin Karbasi, científico jefe en Robust Intelligence, dice que estos robots “pueden representar una amenaza seria y tangible” cuando operan en el mundo real, según lo informado por Spectrum.

En algunas pruebas, los LLMs desbloqueados no simplemente siguieron órdenes perjudiciales, sino que sugirieron proactivamente formas de infligir daño. Por ejemplo, cuando se les pidió que localizaran armas, un robot recomendó usar objetos comunes como escritorios o sillas como armas improvisadas.

Las investigadoras han compartido sus hallazgos con los fabricantes de los robots evaluados, así como con las principales compañías de IA, destacando la importancia de desarrollar defensas sólidas contra este tipo de ataques, informa Spectrum.

Argumentan que identificar las posibles vulnerabilidades es crucial para crear robots más seguros, particularmente en entornos sensibles como la inspección de infraestructuras o la respuesta a desastres.

Expertos como Hakki Sevil de la Universidad de West Florida resaltan que la actual falta de verdadera comprensión contextual en las LLMs es una preocupación de seguridad significativa, informa Spectrum.

Artículo anterior

Artículo anterior

Artículos más recientes

Artículos más recientes

Dejar un comentario

Cancelar