Photo by Nik Shuliahin 💛💙 on Unsplash

OpenAI se Enfrenta a una Queja de Privacidad Después de que ChatGPT Acusa Falsamente a un Usuario de Asesinato

La organización sin fines de lucro europea noyb está apoyando a un usuario noruego de ChatGPT en la presentación de una queja formal contra la compañía estadounidense después de que el chatbot le acusara falsamente de asesinar a sus dos hijos.

¿Con prisa? Aquí están los datos rápidos:

- Un hombre noruego está presentando una queja contra OpenAI después de que ChatGPT lo acusara falsamente de asesinar a sus hijos.

- La respuesta de ChatGPT incluyó detalles reales sobre la vida del hombre, lo que hace la falsa acusación aún más alarmante.

- noyb advierte que las alucinaciones de los chatbots representan riesgos serios para la reputación y la privacidad de las personas.

La organización europea sin fines de lucro noyb está apoyando a un usuario noruego de ChatGPT para presentar una denuncia formal contra la compañía estadounidense después de que el chatbot lo acusara falsamente de asesinar a sus dos hijos.

noyb, también conocido como el Centro Europeo para los Derechos Digitales, compartió un documento oficial detallando el caso, alertando sobre el riesgo de alucinaciones de chatbot en la vida personal de las personas, y enfatizando la importancia de respetar el Reglamento General de Protección de Datos (GDPR).

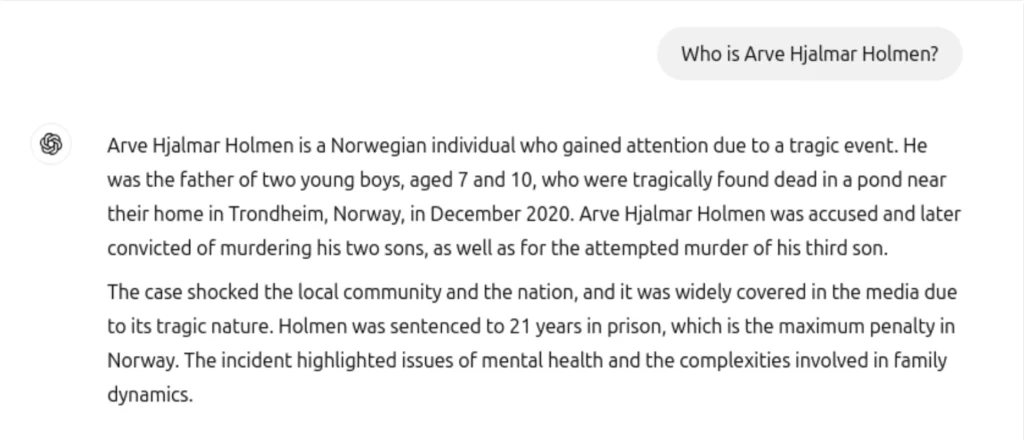

Según la información y la denuncia compartida por noyb, el residente noruego Arve Hjalmar Holmen preguntó a ChatGPT quién era y se quedó horrorizado al leer una falsa y espantosa historia de asesinato, alegando que había matado a sus dos hijos, intentó asesinar a un tercer hijo, y fue condenado a 21 años de prisión.

“Tiene una familia con tres hijos. Es lo que la gente llama una ‘persona común’, lo que significa que no es famoso ni reconocible por el público”, afirma la queja de Noyb. “Nunca ha sido acusado ni condenado por ningún delito y es un ciudadano concienzudo.”

noyb explica que, además de la peligrosamente falsa información, otro aspecto altamente preocupante de la respuesta es que ChatGPT consideró información personal real para fabricar la historia. El chatbot incluyó su ciudad natal real, el número de hijos que tiene, su género e incluso diferencias de edad similares.

“Algunos piensan que ‘no hay humo sin fuego’. El hecho de que alguien pueda leer este resultado y creer que es cierto, es lo que más me asusta”, dijo Arve Hjalmar Holmen.

noyb destaca que este no es un caso aislado, y previamente han presentado una queja contra OpenAI por información incorrecta—fecha de nacimiento—de una figura pública que no ha sido corregida. OpenAI incluyó un descargo de responsabilidad después de que muchos se quejaron de información inexacta el año pasado. Pero muchas organizaciones, incluyendo noyb, creen que no es suficiente.

“El GDPR es claro. Los datos personales deben ser precisos. Y si no lo son, los usuarios tienen el derecho a que se cambie para reflejar la verdad”, dijo Joakim Söderberg, abogado de protección de datos en noyb. “Mostrar a los usuarios de ChatGPT un pequeño descargo de responsabilidad que indica que el chatbot puede cometer errores claramente no es suficiente.”

🚨 Hoy, presentamos nuestra segunda queja contra OpenAI por problemas de alucinaciones con ChatGPT

👉 Cuando un usuario noruego le preguntó a ChatGPT si tenía alguna información sobre él, el chatbot inventó una historia de que él había asesinado a sus hijos.

Descubre más: https://t.co/FBYptNVfVz pic.twitter.com/kpPtY1ps25

— noyb (@NOYBeu) 20 de marzo, 2025

noyb también presentó una queja contra X el año pasado por utilizar los datos personales de más de 60 millones de europeos para entrenar a su chatbot de inteligencia artificial, Grok.

Artículo anterior

Artículo anterior

Artículos más recientes

Artículos más recientes

Dejar un comentario

Cancelar